1 はじめに

MLflow2.7の新機能として、Prompt Engineering UIが導入されました。このUIを使用することで、コードを書くことなく、様々なLLM(Large Language Model)を試すことができます。この記事では、Prompt Engineering UIの基本的な使用方法と、MLflowとの統合方法について紹介します。

1.1 MLflowとの統合

MLflow 2.7には、Prompt Engineering UIが新機能として追加されました。これにより、UI上でプロンプトエンジニアリングの基本手順を実行できます。AI Gatewayを作成し、MLflow Tracking Serverに接続することで、Prompt Engineering UIを利用できます。

2 利用方法

2.1 AI Gatewayの起動

事前にOPENAIのAPIキーを取得しておく必要があります。

AI Gatewayについての詳細はこちらの記事を参考にしてください。

export OPENAI_API_KEY = <OPENAI_API_KEY>

mlflow gateway start --config-path config.yaml --port 70002.2 MLflow Tracking Serverの起動

AI GatewayをMLflow Tracking Serverに接続します。

export MLFLOW_GATEWAY_URI="http://localhost:7000"

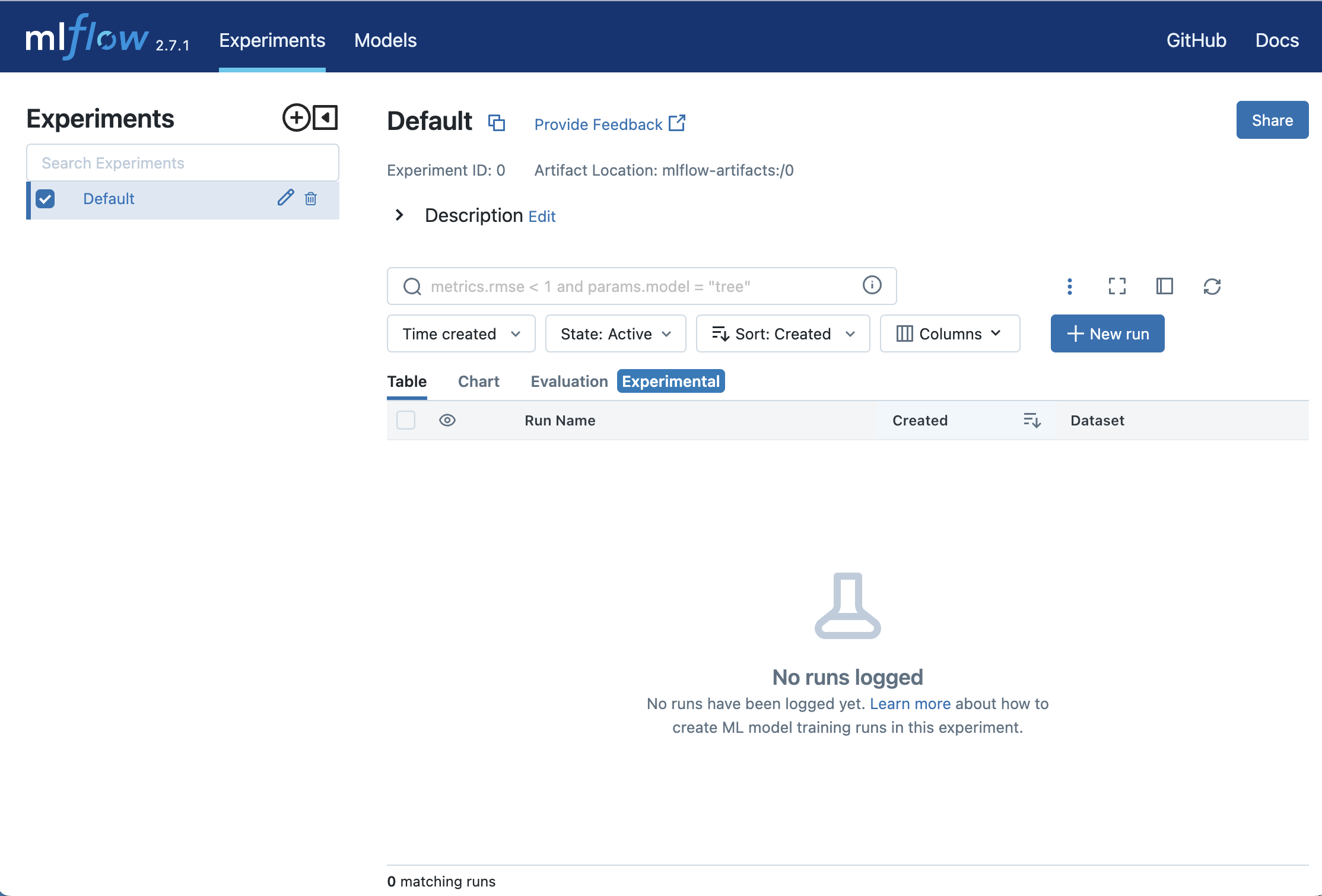

mlflow server --port 50002.3 Prompt Engineering UIへのアクセス

ブラウザでhttp://localhost:7000にアクセスし、Prompt Engineering UIを開きます。

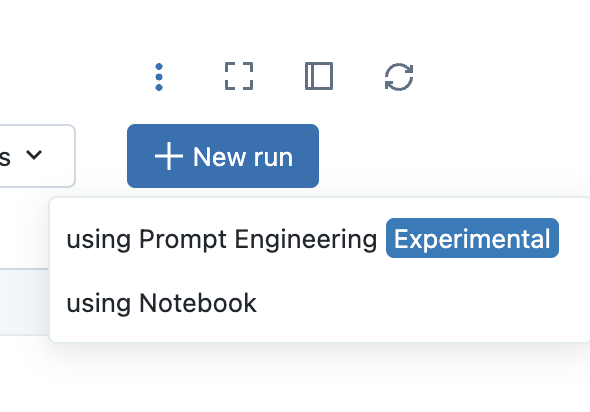

2.4 MLflow Experimentの開始

Prompt Engineering UIからNew Runをクリックし、using Prompt Engineeringを選択します。

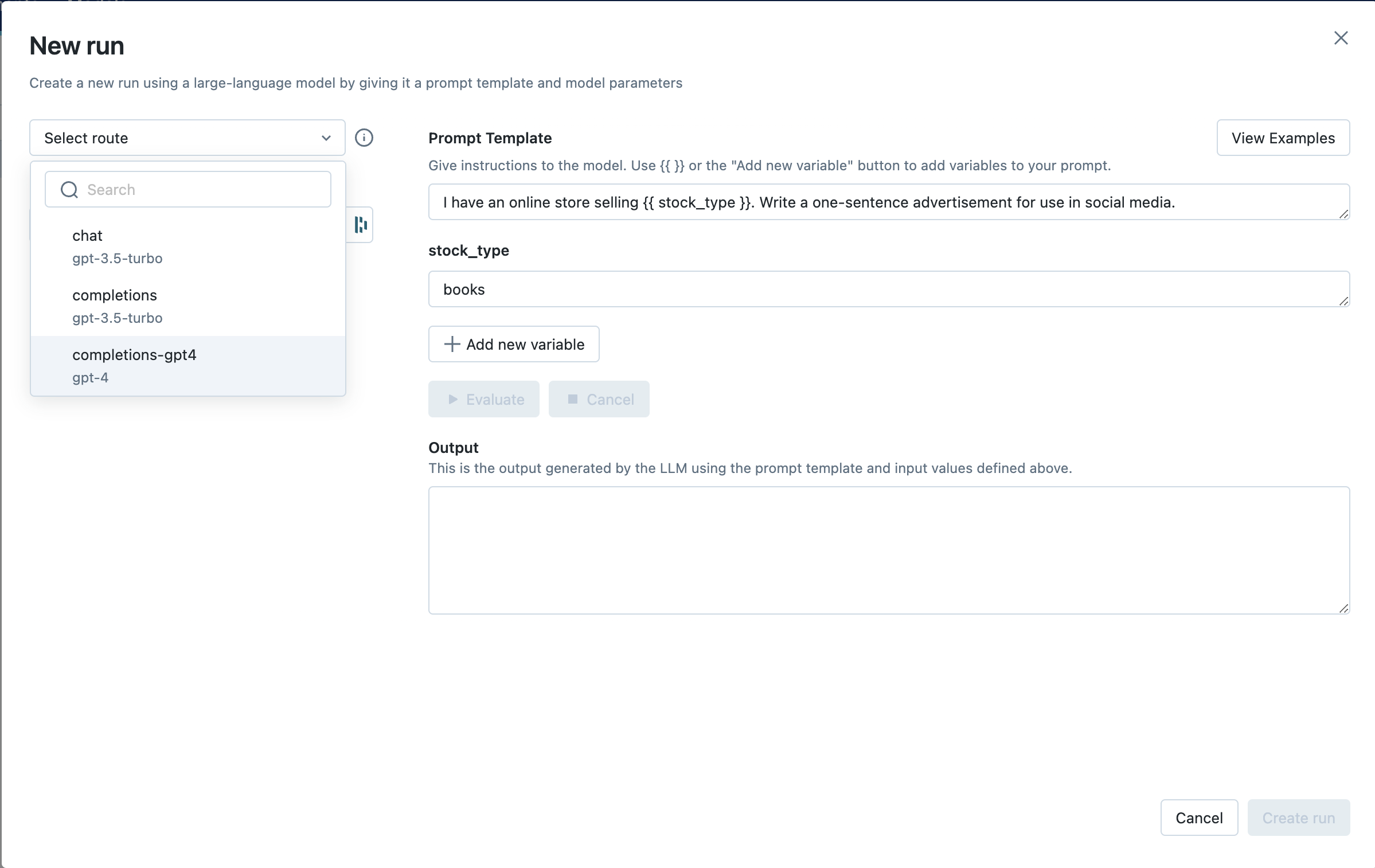

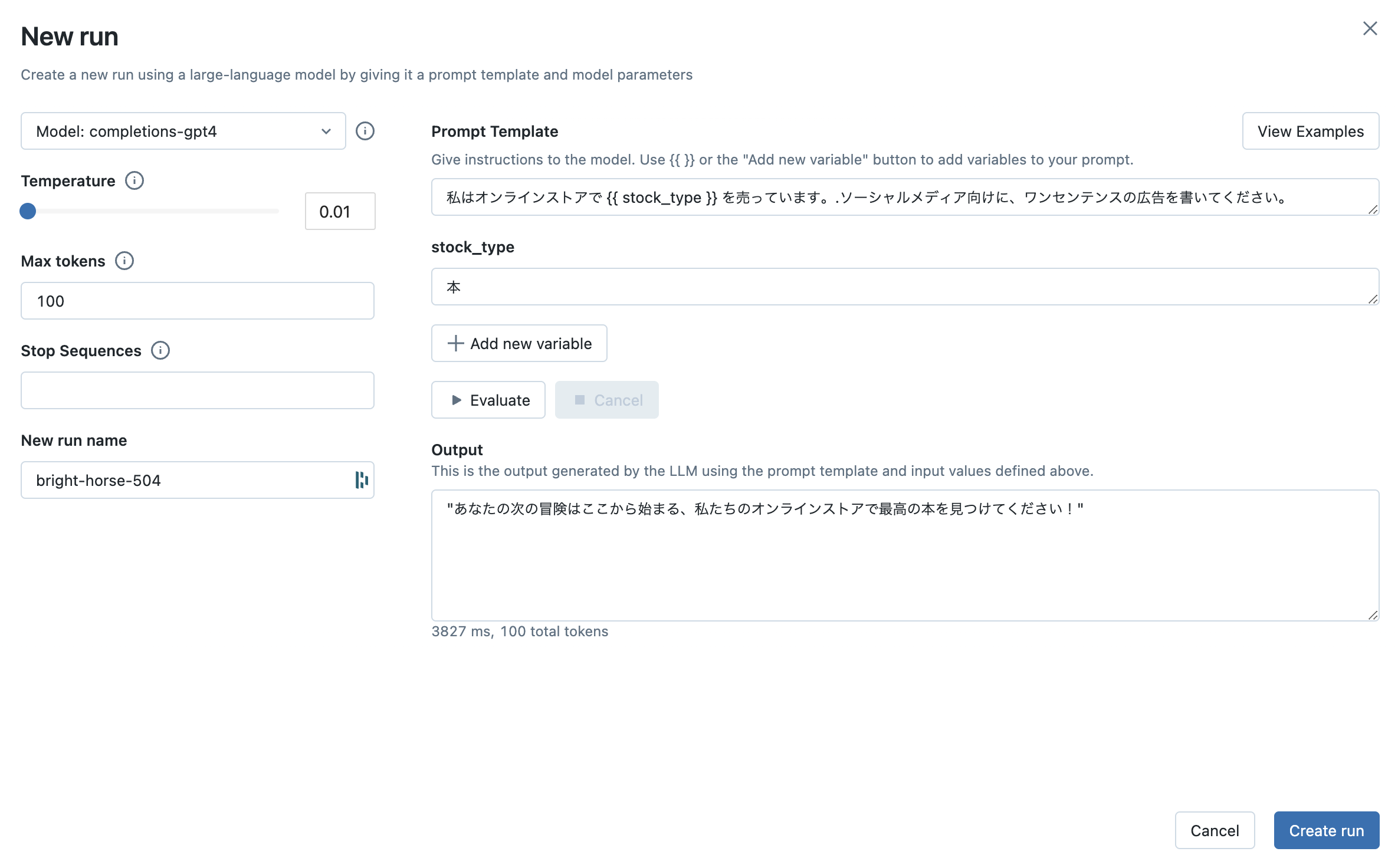

2.5 プロンプトテンプレートの作成

Prompt Engineering Playgroundが開くので、プロンプトテンプレートを作成します。 今回は、英語のデフォルトのプロンプトとその日本語版を試しました。

2.6 評価

Evaluateをクリックします。

2.7 実行

問題なければ実行をクリックします。

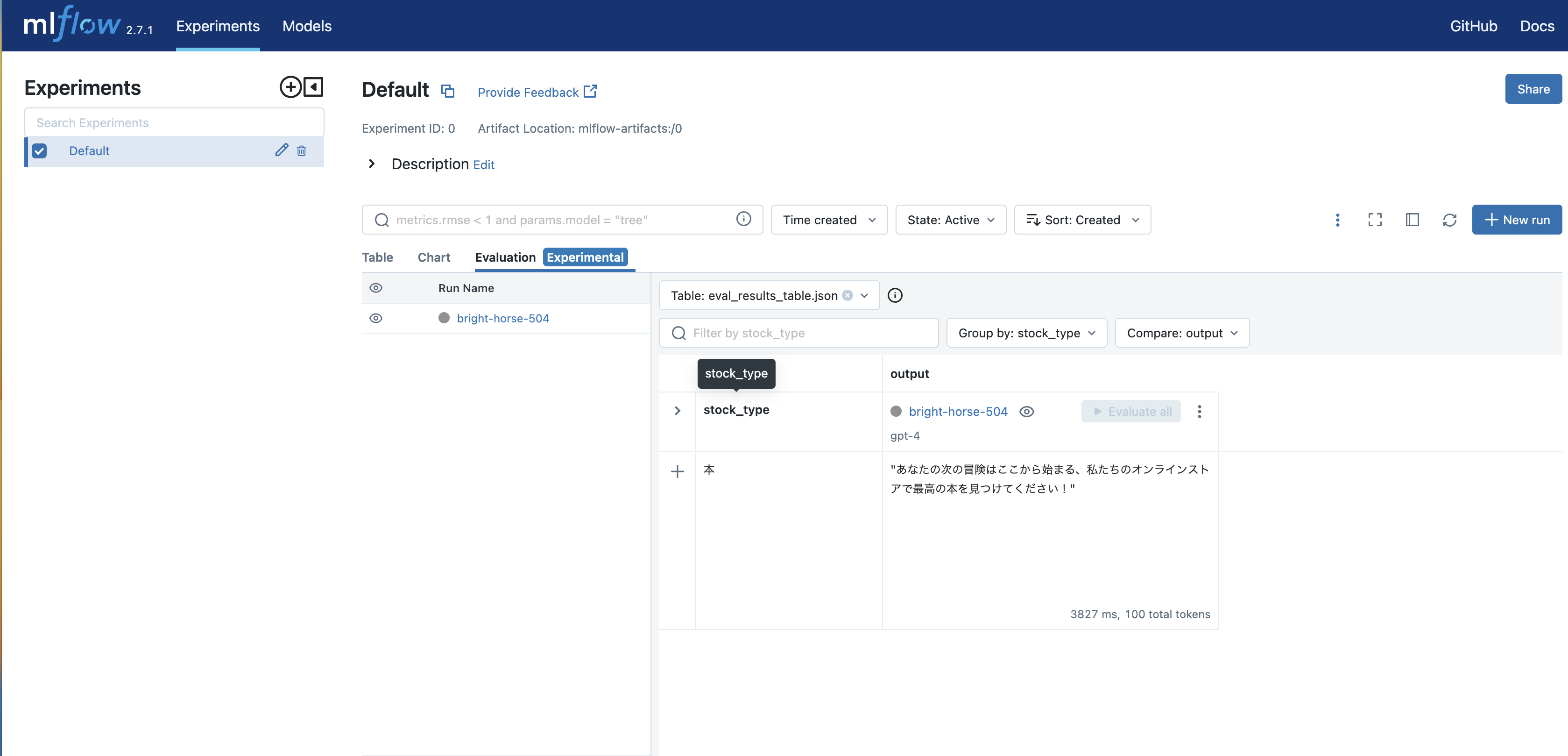

2.8 一覧

実験の一覧が確認できます。

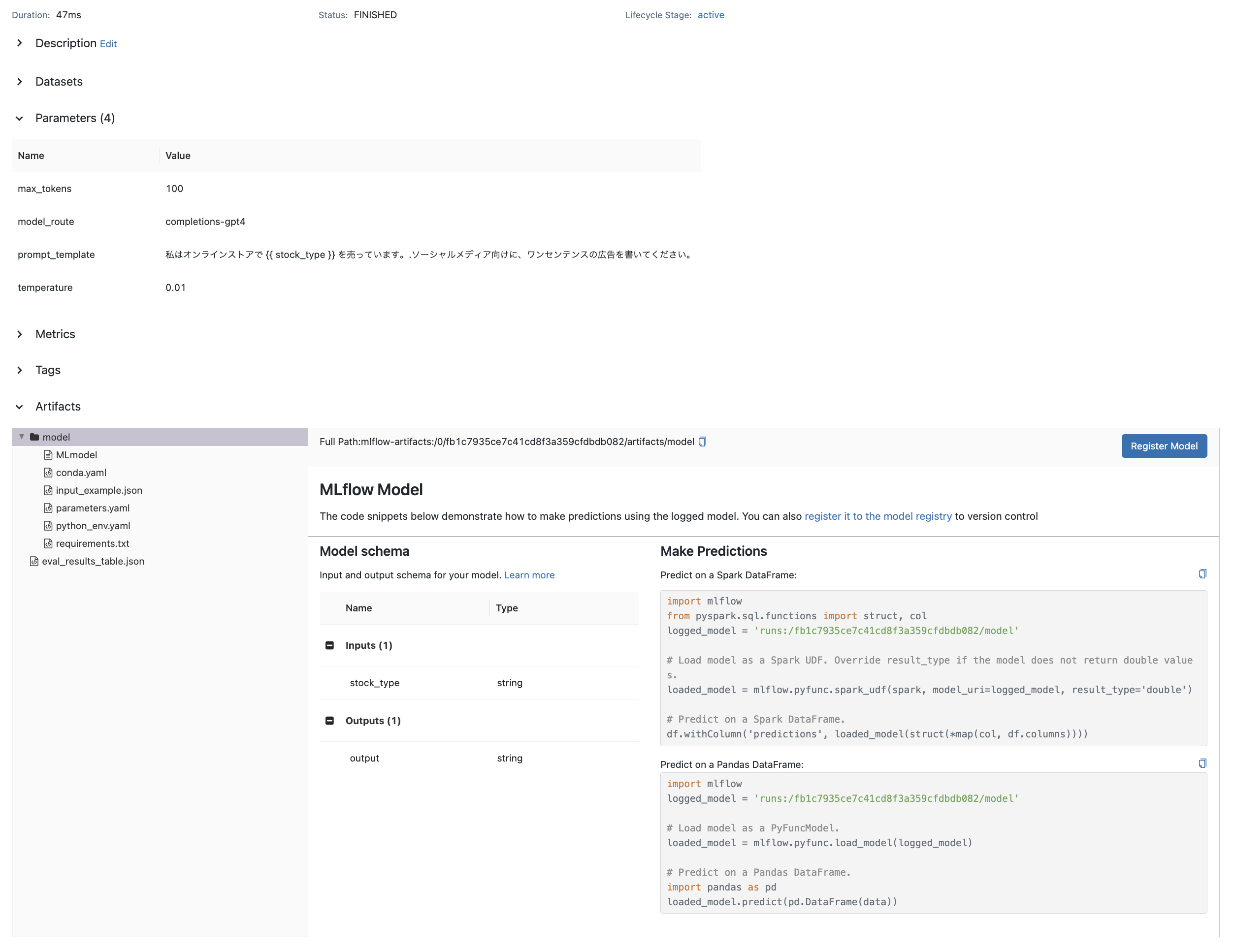

2.9 詳細

詳細ページで、実験に利用したパラメータやモデルが確認できます。

3 まとめ

この記事では、MLflow 2.7の新機能であるPrompt Engineering UIの利用方法と、そのMLflowとの統合方法について解説しました。Prompt Engineering UIを用いることで、ユーザーはコーディングすることなく、様々なLLMを直観的に試すことができます。これにより、開発者やデータサイエンティストは、コードの変更なしに異なるプロンプトやパラメータを素早く試すことができます。

さらに、MLflowにより作成したモデルをサービングすることで、オンライン推論も可能となります。これにより、リアルタイムでのモデルの性能評価や、新しいデータに対するモデルの反応を確認できます。機会があればサービングについても試してみたいです。